服务器负载均衡技术:实现网站高并发访问的解决方案

一、引言

随着互联网技术的飞速发展,网站访问量日益增大,高并发访问成为许多网站面临的挑战。

服务器负载均衡技术作为一种有效的解决方案,能够在多台服务器间分配网络请求,从而提高网站的可用性和性能。

本文将详细介绍服务器负载均衡技术的基本原理、实现方法以及配置过程。

二、服务器负载均衡技术的基本原理

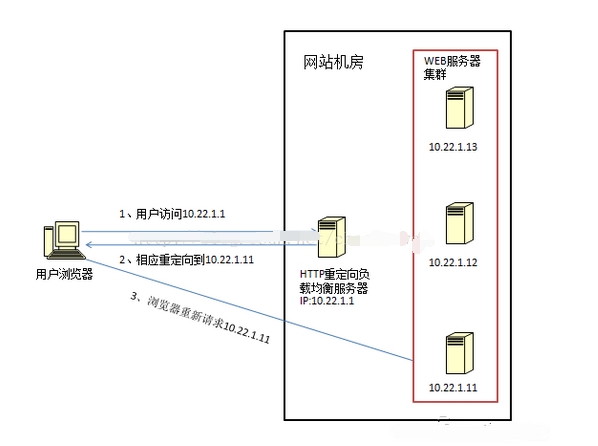

服务器负载均衡技术是通过特定的算法,将网络请求分发到多个服务器上进行处理,从而平衡服务器间的负载。

其核心目的是提高系统的可用性和性能,降低单点故障的风险。

负载均衡的基本原理包括以下几个方面:

1. 请求分发:负载均衡器接收客户端的请求,根据预设的算法(如轮询、权重、IP哈希等)将请求分发到不同的服务器上。

2. 实时监控:负载均衡器会实时监控服务器的负载情况,包括CPU使用率、内存占用、网络带宽等。

3. 动态调整:根据服务器的负载情况,负载均衡器会动态调整请求的分发策略,以确保每台服务器都能得到合理的负载。

三、服务器负载均衡技术的实现方法

服务器负载均衡技术的实现方法有多种,常见的包括硬件负载均衡、软件负载均衡以及云服务提供商提供的负载均衡服务。

1. 硬件负载均衡:通过专门的负载均衡设备实现,具有较高的性能和可靠性。常见的硬件负载均衡器有F5 Big-IP、NetScaler等。

2. 软件负载均衡:通过软件实现负载均衡,可以在服务器上部署负载均衡软件,如Nginx、HAProxy等。软件负载均衡具有灵活性和可扩展性强的优点。

3. 云服务提供商的负载均衡服务:云服务提供商如AWS、阿里云等提供了负载均衡服务,可以通过配置云服务实现高可用的负载均衡。

四、服务器负载均衡配置步骤

以Nginx软件负载均衡为例,以下是服务器负载均衡的配置步骤:

1. 安装Nginx:在负载均衡服务器上安装Nginx软件。

2. 配置upstream模块:在Nginx配置文件中定义upstream模块,指定后端服务器的IP地址和端口号。

3. 配置代理规则:设置Nginx的代理规则,将客户端的请求代理到后端服务器。

4. 启用负载均衡算法:选择适合的负载均衡算法,如轮询、IP哈希等。

5. 保存配置并重启Nginx:保存配置文件并重启Nginx服务,使配置生效。

五、服务器负载均衡技术的优势与挑战

服务器负载均衡技术的优势主要表现在以下几个方面:

1. 提高系统的可用性和性能:通过多台服务器共同处理请求,提高了系统的处理能力和响应速度。

2. 降低单点故障风险:当某台服务器出现故障时,负载均衡器可以将请求分发到其他正常的服务器上,降低了系统的故障风险。

3. 灵活性和可扩展性强:可以通过增加服务器节点的方式提高系统的处理能力,满足不断增长的业务需求。

服务器负载均衡技术也面临一些挑战,如配置复杂、需要实时监控和调整负载情况、网络延迟等。

六、结论

服务器负载均衡技术是实现网站高并发访问的重要解决方案。

通过合理的配置和优化,可以提高系统的可用性和性能,降低单点故障的风险。

在实际应用中,需要根据业务需求和系统特点选择合适的负载均衡技术,并进行合理的配置和优化。